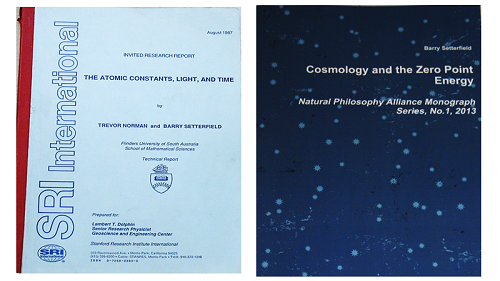

regresa a la página principal or www.setterfield.org YouTube: https://www.youtube.com/watch?v=y3sWg9pDCqE&feature=youtu.be La Velocidad de La Luz y El Comportamiento AtómicoBarry y Helen Setterfield Translator: Lemuel Lara Bienvenido a esta presentación sobre La Velocidad de La Luz y El Comportamiento Atómico. En 1979, cuando tenía 37 años, un amigo que sabía que estaba interesado en las anomalías científicas, así como en la astronomía, me dio un libro interesante sobre anomalías astronómicas. Una anomalía es un hecho o una observación que no concuerda con las teorías prevalecientes. El libro me fascinó. Aquí está una foto del libro:

Del libro, Mysterious Universe (El Universo Misterioso), por William Corliss, p. 691

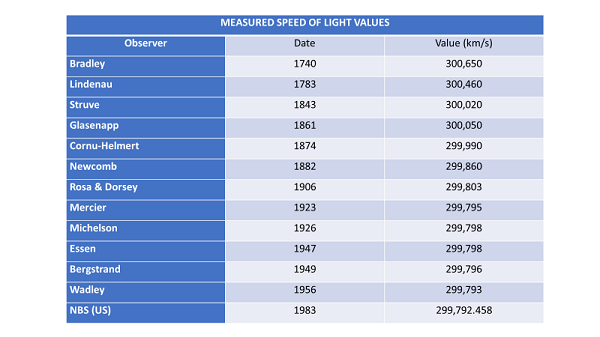

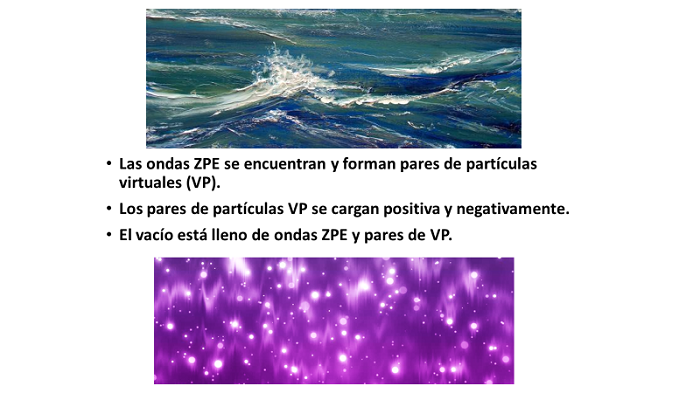

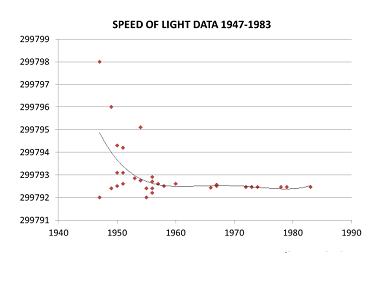

Pero aquí en este libro había tablas y artículos que mostraban una progresión sistemática y descendente en la velocidad de la luz. En general, cada nueva medida fue inferior a la anterior. Las diferencias, aunque relativamente pequeñas, fueron, sin embargo, significativas. Causaron comentarios continuos en las revistas científicas durante muchos años a medida que se realizaban mediciones nuevas y progresivamente más bajas. Velocidad medida de los valores de luz

Intrigado, pensé que podría llevarme un par de semanas en descubrir si había sido un error mecánico o humano lo que condujo a estas diferencias. Curiosamente, artículo tras artículo en revistas científicas fueron revisadas por compañeros científicos, quienes a su vez fueron citados y referenciados, discutiendo estos cambios en las mediciones. Pude encontrar los artículos junto con los informes de los experimentos originales. También encontré los comentarios de quienes hicieron los experimentos. La disminución de la velocidad de la luz resultó ser difícil de descartar, ya fuera de una manera fácil o simplista.

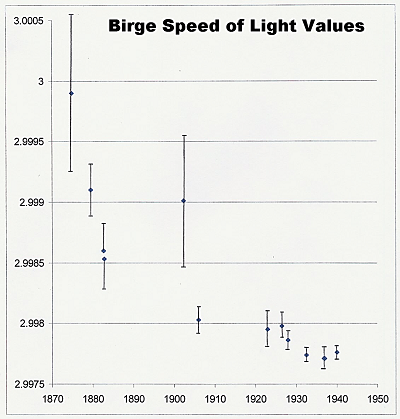

Velocidad de Birge de los valores de luz

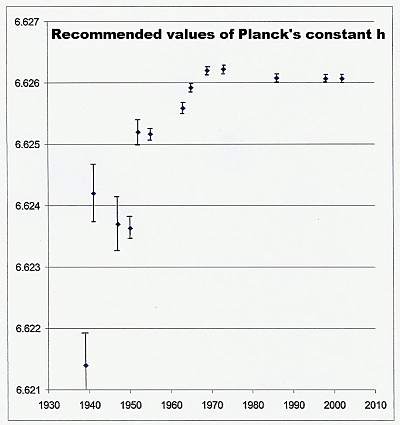

Valores recomendados de la constante de Planck, 'h'

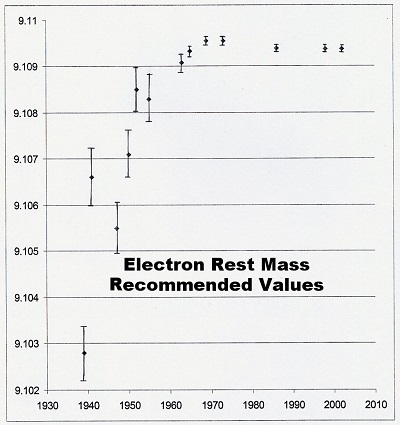

Al discutir los datos que permiten que la medida de h sea posible, el profesor J.H. Sanders señaló en 1965 que el valor creciente de la constante de Planck puede explicarse solamente en parte por las mejoras en la resolución instrumental y los cambios en el valor aceptado de otras constantes. Parecía que sí estaba ocurriendo un aumento genuino en la constante de Planck, h. Valores recomendados de masa de descanso de electrones

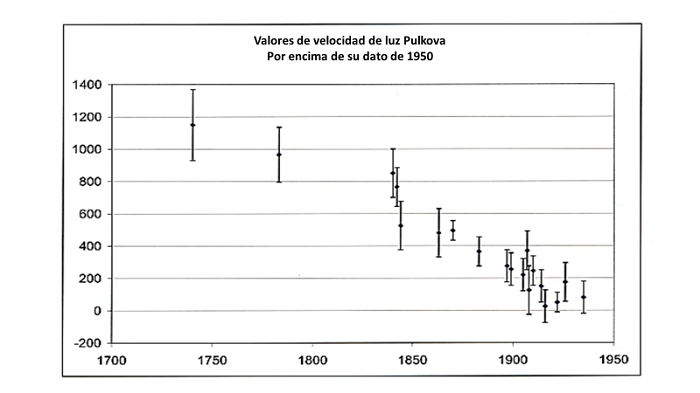

La gráfica de los resultados de Pulkovo revela una tendencia descendente constante que no podría deberse a cambios de equipo o técnicas de medición. Sin embargo, la tendencia a bajar siguió siendo muy evidente. En total, se hicieron 20 determinaciones de la velocidad de la luz. Cada determinación involucró más de 10,000 conjuntos de observaciones, por lo que más de 200,000 observaciones separadas estuvieron involucradas. La fiabilidad de esta tendencia se puede evaluar matemáticamente. Las barras que ve a ambos lados de los puntos en el gráfico muestran que PODRÍA haber un error que se extienda tanto a cada lado de la medición. Se llaman barras de error. Pero incluso si se consideran todos los posibles errores, la velocidad de la luz aún se mide como decreciente. La posibilidad de equivocarse El viejo estándar era una oportunidad en 20, o 1/20 a 0,05 Así que la propuesta, P, fue aceptada si P < 0.05 El nuevo estándar es una oportunidad en 200, o 1/200 – 0.005 Así que la propuesta, P, ahora se acepta si P , 0.005 Muy pocos requieren 1 oportunidad en 1000 de estar equivocados ¿Qué menas la proposición se acepta si P < 0.001 Los datos de Pulkovo tienen 1/10.000 posibilidades de equivocarse; así que P < 0.0001 Cuando una tendencia, como la posible disminución de la velocidad de la luz, se considera científicamente, es extremadamente raro que la probabilidad se considere 100% segura. Hasta hace poco, sin embargo, la verdad de una tendencia se aceptaba si el riesgo de equivocarse era inferior a 1 en 20. Recientemente, esa restricción se hizo más estricta, y la probabilidad ahora tiene que exceder la posibilidad de que sea incorrecta MENOS de 1 vez en 200 Aun así, es casi inaudito que cualquier científico que requiera una tendencia de datos tenga una probabilidad de más de una posibilidad en mil de estar equivocado antes de que esa probabilidad sea aceptada. Sin embargo, los datos de Pulkovo sugieren una tendencia a la descomposición con menos de una posibilidad en 10,000 de estar equivocado. La velocidad de la luz definitivamente estaba disminuyendo.

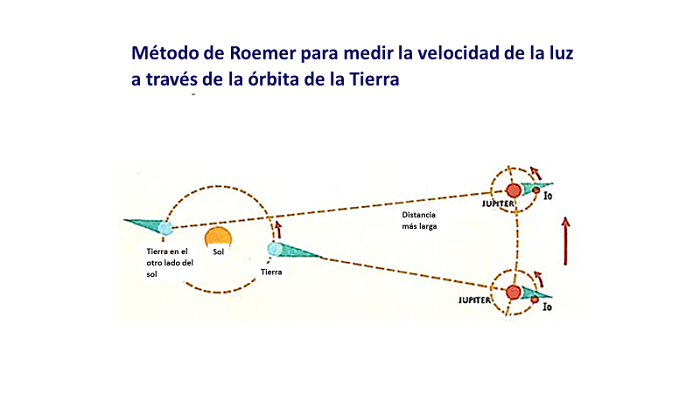

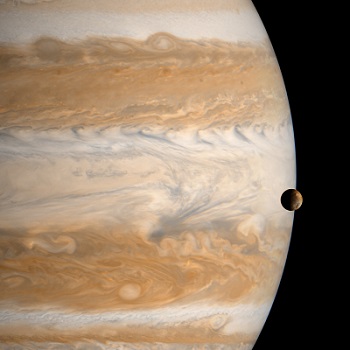

Hasta 1675, se pensaba que la luz viajaba a una velocidad infinita; en otras palabras, se movía instantáneamente. En ese año, Ole Roemer demostró que ese no era el caso. Usando los primeros telescopios, los científicos habían medido la cantidad de tiempo que una de las lunas de Júpiter, Io, tardó en darle la vuelta a su planeta. Cronometraron los eclipses cuando Io fue detrás de Júpiter y desapareció o cuando emergió al otro lado de Júpiter. Pero también se vio que esos ya predichos tiempos de eclipse parecían alargarse a medida que la Tierra y Júpiter en sus órbitas aumentaban en distancia entre sí. La diferencia en el tiempo, razonó Roemer, se debía al tiempo que le toma a la luz viajar a través del diámetro de la órbita de la Tierra. Roemer utilizó estas observaciones para mostrar que la velocidad de la luz era una velocidad definida y no infinita. A medida que los dos planetas se alejaban el uno del otro, el tiempo para que la luz cruzara la distancia entre ellos aumentó. Luego, cuando se acercaron nuevamente, el tiempo disminuyó.

Sin embargo, por tres razones, el cálculo de la velocidad de la luz de Roemer no se puede considerar hoy. La primera es que dependían de la inspección visual de los tiempos del eclipse, y eso es muy subjetivo y tenía una variación típica de al menos 20 segundos. El segundo es que la órbita de Io es elíptica, por lo que su velocidad varía. El tercero es que nuestras naves espaciales y nuestras observaciones modernas han demostrado que la órbita de Io está cambiando de manera continua y medible. Esto se debe a la interacción gravitacional y magnética de Io con Júpiter y con dos de sus lunas vecinas. Esto significa que no podemos verificar los datos de Roemer de hace más de 300 años con las observaciones de hoy.

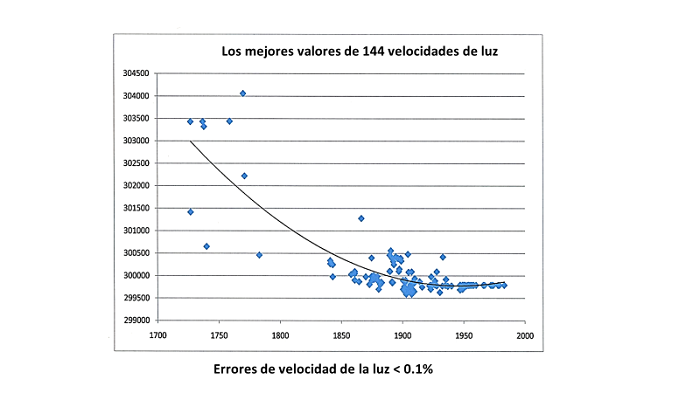

No tomando en cuenta todos los valores obtenidos por aquellos que utilizan el método de Roemer, ha habido 155 determinaciones de la velocidad de la luz por 15 métodos diferentes, cada uno con miles de experimentos individuales. El gráfico de los resultados de esos experimentos con errores inferiores al 0.1% se muestra aquí. Estas son las medidas, a partir de 1726, que se realizaron con equipos especiales. A partir de esta gráfica, se puede ver que hay una disminución constante en el valor de la velocidad de la luz en lugar de una distribución aleatoria de resultados alrededor de un valor fijo.

Cada uno de los 15 métodos de medición muestra una disminución estadística al igual que los resultados de Pulkovo. Las 155 determinaciones juntas también muestran una disminución. El perito en estadística, Alan Montgomery, y el físico Lambert Dolphin hicieron un análisis independiente. Reexaminaron todos los datos y confirmaron que hubo una disminución en el valor de c que fue estadísticamente significativo. La tendencia fue significativa en el intervalo de confianza del 95% o mejor. Su análisis fue publicado en una revista científica revisada por expertos en 1993. En 1931, el astrónomo francés M.E.J. Gheury de Bray escribió en la revista científica Nature: “Si la velocidad de la luz es constante, ¿cómo es que, invariablemente, las nuevas determinaciones dan valores inferiores a la obtenida? ... Hay veintidós coincidencias a favor de una disminución en la velocidad de la luz, mientras que no hay una sola contra ella". Gheury de Bray continuó diciendo algo que todavía es relevante hoy en día: “Creo que, en cualquier otro campo de investigación, tal discrepancia entre observación y teoría se sentiría intolerable. Por qué es que se tolera en el presente caso no es evidente. Sin embargo, es de asegurarse que, si se aceptara una disminución en la velocidad de la luz por motivos teóricos, y si algún físico equivocadamente intentara demostrar que es una constante, ¡las presentes observaciones serían puestas como evidencia para silenciarlo de manera concluyente!”

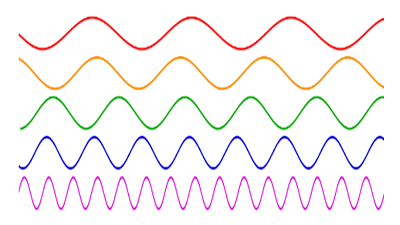

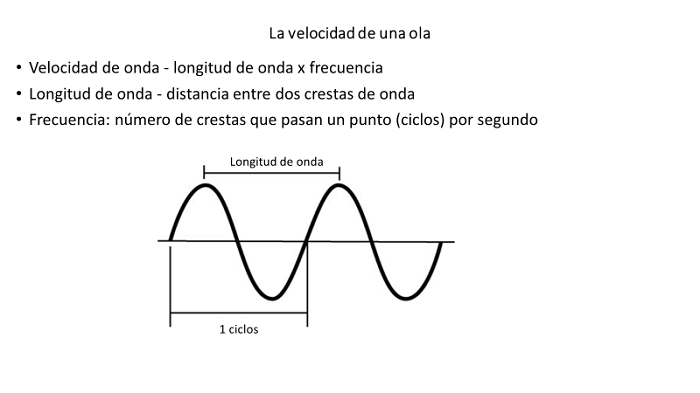

La razón de Birge para rechazar tal disminución de la velocidad de la luz se relacionó con el hecho de que los colores mismos permanecieron iguales a lo largo del tiempo, lo que significa que las longitudes de onda no han cambiado. Si lo hubieran hecho, hay instrumentos que podrían captar eso. Birge señaló que las longitudes de onda y los estándares de longitud demostraron experimentalmente que no cambiaron con el tiempo. Luego concluyó que "si el valor de c ... realmente está cambiando con el tiempo, pero el valor de (la longitud de la onda) en términos del medidor estándar no muestra el cambio correspondiente, entonces necesariamente se deduce que el valor de cada frecuencia atómica ... Debe estar cambiando. Tal variación es obviamente muy improbable ..."

Sabemos que la velocidad de la luz es igual a la frecuencia, o al número de ondas más allá de un punto dado en una cantidad de tiempo dado, multiplicado por las longitudes de onda de la luz involucrada. Entonces, lo que Birge dice aquí es que, dado que las longitudes de onda no cambian a medida que cambia la velocidad, esto solo puede significar que la frecuencia cambia en la misma proporción que la velocidad. La razón por la cual Birge conectó la velocidad de la luz con otras frecuencias atómicas es porque la emisión de un fotón de luz desde un átomo, en realidad, depende de otros procesos atómicos y frecuencias atómicas. Por lo tanto, los procesos atómicos deberían haber estado cambiando en la misma proporción que la velocidad de la luz estaba cambiando. Pero Birge pensó que era improbable que las frecuencias atómicas estuvieran cambiando sincrónicamente con la velocidad de la luz. Esto requeriría, entre otras cosas, que la velocidad a la que los electrones rodean el núcleo atómico fuera proporcionalmente más rápida cuando la velocidad de la luz fuera mayor. ¡Esto podría generar problemas con las ideas aceptadas! Las discusiones sobre los posibles cambios en algunas constantes atómicas y la velocidad de la luz habían estado ocurriendo en varias revistas revisadas por pares durante casi cien años. Entonces Birge, el "guardián de las constantes" escribió una sorprendente introducción a un artículo en agosto de 1941. Tenga en cuenta que el énfasis es del mismo Birge:

Este artículo efectivamente cerró toda discusión sobre un posible cambio en la velocidad de la luz. Desde 1940 en adelante, se ha aceptado y enseñado que la velocidad de la luz, c, es constante. Echemos un vistazo, ahora a esas líneas de evidencia que contradicen las afirmaciones de Birge con respecto a la constancia de c. Él sabía sobre el primero y sabía lo suficiente sobre el segundo como para haberlo considerado seriamente.

La primera línea de evidencia la conocía Birge muy bien. Se trata de algo llamado la Constante de Estructura Fina, o "Alfa". La designación original de Alfa se definió como la velocidad del electrón en la órbita más baja, la órbita más cercana al núcleo, dividida por la velocidad de la luz. Los datos indicaron que Alfa era una cantidad inmutable. Esto significa que la velocidad de la luz y la velocidad del electrón iban a la par. Había dos opciones. Ambas cantidades PUDIERAN HABER permanecido iguales desde el principio. Pero el MISMO resultado ocurre si cada una está cambiando en proporción perfecta entre sí. Mientras la relación sea constante, Alfa es una constante. Birge lo sabía. Sabía que, al ser una constante, Alfa no tenía una sola posibilidad. Pero, la única opción que aceptaría era la que requería que tanto la velocidad de la luz como la velocidad orbital de los electrones fueran cantidades fijas. Ni siquiera iba a considerar la opción donde la velocidad de la luz y la velocidad orbital de los electrones pudieran estar cambiando en proporción exacta entre sí. La segunda línea de evidencia implica el hecho de que hay dos formas de medir el tiempo. Con la que estamos familiarizados en nuestra vida cotidiana es con el tiempo orbital: el tiempo que le toma a la tierra dar la vuelta al sol o a la luna dar la vuelta a la tierra. Esta forma de cronometraje depende de la gravedad. La segunda forma de medir el tiempo es a través de mediciones de procesos atómicos, o frecuencias atómicas, como el tiempo que le toma a un electrón dar una vuelta alrededor de su núcleo.

El tiempo gravitacional nos da lo suficiente para vivir nuestras vidas en términos de horas, minutos e incluso segundos. Sin embargo, el tiempo atómico, o las frecuencias atómicas, pueden determinar cantidades de tiempo mucho más pequeñas, y eso es muy útil en algunos campos de la ciencia. El profesor Birge sabía que había dos formas posibles de medir el tiempo. Se negó absolutamente a considerar que estos dos "relojes" pudieran funcionar a ritmos diferentes. Si corrieran a velocidades diferentes, entonces muchos cálculos científicos tendrían que ser reconsiderados. Tenía razón, pero veamos qué indica la evidencia de observaciones desde su época. Como se mencionó anteriormente, la constante de Planck, conocida como h, es una medida de la fuerza de la energía de punto cero. Birge mismo había notado que los valores de la constante de Planck estaban aumentando. Más tarde, en 1965, el astrofísico Jean Kovalevsky del Observatorio de París señaló que si la constante de Planck, h, estaba cambiando, entonces las frecuencias atómicas también estarían cambiando en comparación con las frecuencias del reloj orbital, llamado el estándar orbital. De hecho, el aumento de los valores de h implicaba que el reloj atómico en sus diversas formas se desaceleraba en comparación con el reloj orbital. Otros también han señalado que los datos de otras constantes sugieren que los relojes atómicos y orbitales pueden estar funcionando a diferentes velocidades.

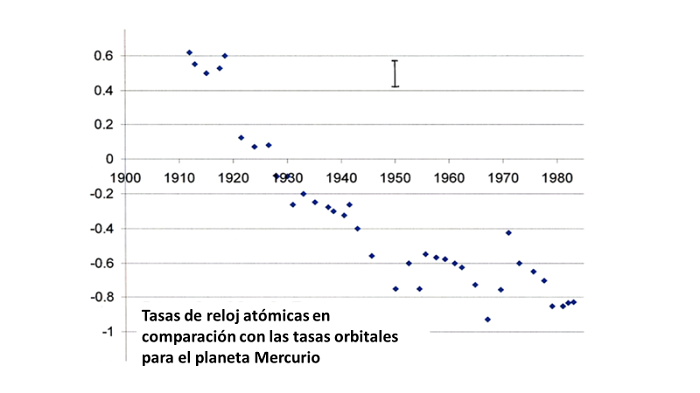

La gravedad misma no cambia a través del tiempo. Esto significa que el tiempo medido por la gravedad, nuestro reloj orbital, ha estado funcionando a un ritmo constante. Esto contrasta con la posibilidad de que los tiempos atómicos hayan cambiado. El Dr. Thomas Van Fandern, del Observatorio Naval de EE. UU., Washington, realizó una serie de mediciones de las tasas de reloj atómico en comparación con el estándar orbital. Van Flandern recolectó datos desde 1955 hasta 1981 utilizando rangos basados en mediciones lunares y planetarias con laser. Después de su estudio, Van Flandern concluyó que "la cantidad de segundos atómicos en un intervalo orbital es cada vez menor. Presumiblemente, si el resultado tiene alguna generalidad, esto significa que los fenómenos atómicos se están desacelerando con respecto a los fenómenos [orbitales] ". Otros observatorios han realizado investigaciones similares. Los datos de Yuri Kolesnik para los planetas Mercurio, Venus y el Sol muestran bien la tendencia. Un análisis realizado por C.J. Masreliez en 2004 concluyó que “las derivaciones planetarias que Kolesnik y varios otros investigadores han detectado se basan en observaciones modernas precisas y utilizan el tiempo atómico. Por lo tanto, esas derivaciones son indudablemente reales." El tiempo atómico y el orbital parecían estar funcionando a diferentes velocidades.

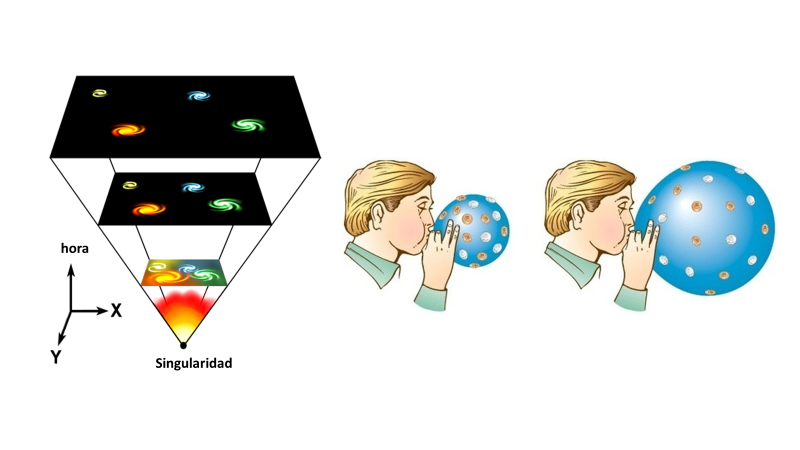

La gráfica en la pantalla en este momento se ha trazado a partir de los datos proporcionados por Yuri Kolesnik. Muestra la progresión del tiempo orbital en años en el eje horizontal, y los datos correspondientes en tiempo atómico para el planeta Mercurio en el eje vertical. Estos dos conjuntos de medidas se toman de manera muy simple: uno se realiza cronometrando los eventos astronómicos de Mercurio utilizando nuestro calendario orbital y relojes o relojes mecánicos. La otra forma mide los eventos usando el tiempo atómico y los relojes atómicos. Estas dos medidas no se han mantenido juntas, sino que se han estado separando. Esta gráfica confirma que el reloj atómico ha bajado su velocidad en comparación con el estándar orbital. Si recuerdas, Birge se había opuesto a la idea de que la velocidad de la luz estaba cambiando porque eso también indicaría un cambio en otros procesos atómicos. Consideró que esa opción estaba en algún lugar entre lo imposible y lo altamente improbable. Sin embargo, podemos ver ahora que otros procesos atómicos han mostrado cambios, por lo que esta objeción de Birge es anulada por los datos más recientes. Estas mediciones, por cierto muy precisas, han demostrado que no todo lo que la ciencia solía considerar como una constante ha sido en realidad una constante. Por otro lado, algunas combinaciones de constantes han demostrado ser invariables. Por ejemplo, se ha demostrado que la constante de Planck, h, y la velocidad de la luz, c, cuando se multiplican juntas siempre dan el mismo número. Estos datos provienen de observaciones astronómicas en todo el universo, incluso en las partes más distantes. Pero ten en cuenta. Esto no significa necesariamente que cada una por sí misma haya sido invariable. Lo que sí significa es que SI una cambia, la otra también ha cambiado, pero en la dirección opuesta. Es como el número 12. Puede obtener 12 de varias maneras: 1 x 12, 2 x 6 y 4 x 3. Tenga en cuenta que, si un número se duplica, el correspondiente se divide. Por lo tanto, siempre existe la posibilidad de que todo se haya mantenido igual. Pero, cuando las mediciones mismas muestran un cambio, pero el resultado final es invariable, tenemos que aceptar que estos cambios están en sintonía entre sí, o son sincrónicos. Entonces, en términos de hc, h debe ser proporcional a 1/c exactamente. Hay otros ejemplos en los que se puede ver este tipo de relación sincrónica. La relación entre la masa de electrones, m, y la constante de Planck, h, se expresa como m/h2 en algunas cantidades. Esta relación siempre da como resultado el mismo número: es invariable. Pero, de nuevo, esto no significa que m o h2 tengan que permanecer constantes, solo que, si uno cambia, el otro está cambiando en una proporción directa. Ahora mira. Este comportamiento de m indica que todas las masas atómicas, como m, son proporcionales a h2. PERO, h es proporcional a 1/c, ¿verdad? Esto significa que, si ambos son cuadrados, h2 es proporcional a 1/c2. Cuando juntamos esto, eso significa que las masas atómicas, m, son proporcionales a 1/c2. Entonces, a medida que m cambia, entonces c2 está cambiando en proporción inversa. Esto significa que mc2 es fijo. Observa esta famosa ecuación: E = mc2. Como la masa y el término c2 están en proporción inversa entre sí, eso significa que E, energía, siempre se conserva. No ganas ni pierdes energía a medida que la masa y la velocidad de la luz cambian. De hecho, todas estas relaciones muestran que la energía se conserva a medida que varían las constantes físicas. Los experimentos de laboratorio que involucran energías de reacción de partículas atómicas han confirmado que esto es cierto. En este punto, podemos ver que los datos reales muestran que algunas de las constantes que se consideran constantes están cambiando de valor. Esto no se menciona a menudo en los cursos universitarios, pero los datos están ahí. De hecho, si se excluye la velocidad de la luz, aparecen tendencias confirmatorias en 475 mediciones de otras 11 cantidades atómicas. ¿Por qué está pasando esto? También podríamos preguntarnos si hay un único factor común involucrado en todos estos cambios. Veamos algunas pistas. La primera pista fue de un físico llamado Max Planck. Escribió dos documentos muy importantes en los primeros años del siglo XX. En el primer artículo, en 1901, introdujo un término matemático para responder a un problema que tenían los físicos. Pero en ese momento era solo un término matemático. Planck no estaba satisfecho con solo insertar un término para corregir las matemáticas, por lo que siguió trabajando. Luego, en su segundo artículo, en 1911, identificó ese término como teniendo un significado físico real. Ese término ahora se llama "Constante de Planck" y generalmente se designa como la letra h. Allí, en ese artículo de 1911, señaló que la constante de Planck, h, era una medida de la fuerza del vacío de la Energía de Punto Cero (EPC). Las mediciones de la Constante de Planck comenzaron en la década de los 1920 y posteriormente mostraron que h no era constante, sino que aumentaba. Como la constante de Planck aumentaba, esto implicaba que la fuerza de la EPC también aumentaba. La energía de punto cero se discutió en el segundo video de esta serie. En esa sesión, se demostró que era el resultado de un universo en expansión. La energía se coloca en la tela del espacio a medida que se expande de la misma manera que la energía se pone en la tela de un globo que se infla. En el espacio, esta energía aparece como la Energía del Punto Cero, la EPC.

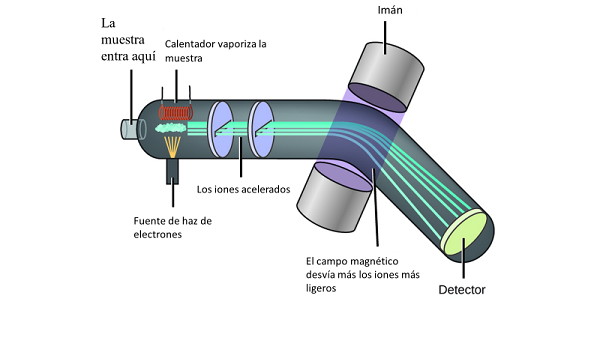

A medida que el universo continuó expandiéndose, la fuerza de la EPC continuó acumulándose. Para refrescar aún más tu memoria, la energía de punto cero consiste en una cantidad masiva de ondas electromagnéticas que impregnan todo el espacio. Estas ondas consisten de todas las longitudes de onda, pero la gran mayoría están en el extremo más corto del espectro. Entonces, la primera pista, el valor creciente de la constante de Planck, h, nos lleva a sospechar que la fuerza creciente de la EPC puede ser responsable de los cambios observados, ya que h es una medida directa de la fuerza de la EPC. La segunda pista requiere que comprendamos el efecto de la Energía de Punto Cero en las masas subatómicas. Aquí, debemos mencionar cómo se miden las masas subatómicas: no podemos ponerlas en una balanza para ver cuánto pesan, por lo que tenemos que hacer otra cosa.

Casi todas las partículas subatómicas tienen una carga, positiva o negativa. Eso significa que responderán a un campo magnético. Y así es como podemos medir su masa, por la cantidad que son desviadas por los campos magnéticos. Cuanto mayor es la desviación, menor es la masa. Durante los años que trabajamos con partículas cargadas, la medición de las masas de electrones fue la más completa. Cuando hicimos estas mediciones, descubrimos que se desviaban un poco menos, luego un poco menos nuevamente. Estaban acumulando masa. ¿Qué estaba pasando? Recuerda que las ondas de la EPC son mucho más numerosas en el extremo corto del espectro electromagnético. Son lo suficientemente pequeñas como para mover las partículas subatómicas, incluyendo a los electrones. Cuanto más fuerte es la EPC, más ondas se impactan en las partículas subatómicas, lo que produce una mayor sacudida. Cuanto más se agita el electrón, más masa aparente tiene. Las ecuaciones del proceso muestran que esta masa es proporcional a la fuerza de la EPC al cuadrado, es decir a h2.

En este punto, tenemos tanto a la constante de Planck como a las masas de partículas subatómicas unidas a la energía del punto cero. Como resultado, la velocidad de la luz también está vinculada a la Energía del Punto Cero. La EPC es la causante de varios de estos efectos "secundarios", incluyendo a la constante de Planck, a las masas subatómicas y a la velocidad de la luz. Ninguno de los "niños" causa "otro niño". Todos dependen de la causa principal, la energía del punto cero.

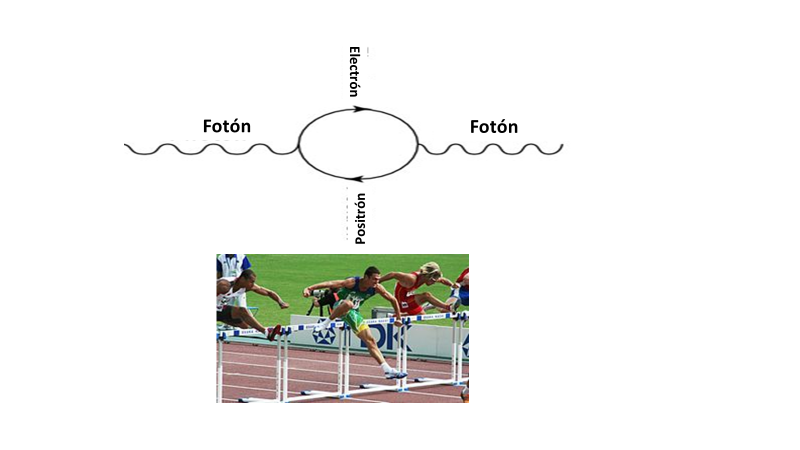

Entonces, ¿cómo afecta la EPC a la velocidad de la luz? Como se mencionó, la energía de punto cero se compone de ondas de todas las longitudes en el espectro electromagnético. Pero hay una gran preponderancia de ondas en el extremo corto del espectro. Estas ondas van en todas las direcciones a la vez, por lo que constantemente chocan entre sí. Piense en las olas en el océano, si las ondas cruzadas golpean, se forman capas blancas y se apagan rápidamente. Cuando las ondas de la EPC golpean, también tienen un efecto. Por el instante más breve de tiempo, el impacto causa una pequeña concentración de energía, lo que permite que se forme algo llamado par de partículas virtuales, mas conocidas como ‘pares partícula-antipartícula’. Una de las dos es negativa y la otra es positiva, y por esa razón vuelven a juntarse casi de inmediato, siguiendo su camino mientras la energía se agita hasta el próximo golpe.

Pero mientras existen, por ese breve momento en el tiempo, actúan como partículas físicas y pueden absorber un fotón de luz. Cuando se vuelven a juntar, ese fotón se libera para seguir su camino a su velocidad original. Si solo hubiera un par de partículas virtuales para navegar, eso realmente no afectaría la velocidad de la luz, pero a medida que la EPC se acumulaba con el tiempo, los fotones de luz tenían que navegar por más y más de estas partículas virtuales y el efecto acumulativo fue el retraso de la llegada del fotón de luz a su destino final. Piensa en un corredor que supera obstáculos. Un obstáculo no causaría mucho retraso en llegar a la línea de meta. Sin embargo, cien obstáculos causarían un gran retraso, independientemente de la velocidad del corredor entre los obstáculos. De manera similar, podría ser útil tener en cuenta que no era la velocidad de la luz lo que estaba disminuyendo. Más bien fue el hecho de que el número de obstáculos con los que tuvo que lidiar en su camino estaba aumentando. A medida que aumentaba la fuerza de la EPC, el espacio se volvió "más grueso", o más cargado con partículas virtuales. Actualmente, se puede calcular que en cualquier instante hay al menos 1058 pares de partículas virtuales por pulgada cúbica. Esa es la figura seguida de 58 ceros. 10,000,000,000,000,000,000,000,000,000,000,000,000,000,000,000,000,000,000,000 Por lo tanto, el incremento de la fuerza de la EPC es la razón por la que la velocidad medida de la luz ha estado perdiendo velocidad, o sea, ha desacelerado. Entonces, la velocidad de la luz también está relacionada directamente con la Energía de Punto Cero.

Una razón para este aplanamiento se puede encontrar en la introducción de relojes atómicos en los laboratorios de todo el mundo a partir de 1955. Los relojes atómicos miden el tiempo a un ritmo de acuerdo con el comportamiento de la velocidad de la luz. Esto significa que medir uno usando el otro no producirá ninguna evidencia de variación en cualquiera de las cantidades.

Esta fijación de la velocidad de la luz como una cantidad invariable introduce una última gran objeción. Esto tiene que ver con Einstein y sus famosas teorías de la relatividad. Para que sus teorías funcionaran física y matemáticamente, Einstein requirió dos cosas: primero, que la velocidad de la luz fuera una constante fija y, segundo, que no era posible realizar mediciones absolutas de ningún movimiento. Eso fue porque sus teorías requirieron que no hubiera un marco de referencia universal contra el cual ese movimiento se pudiera medir.

En otras palabras, ya fuera que 1. hubiera un marco de referencia absoluto en el universo contra el cual se pudiera medir todo el movimiento, o 2. si la velocidad de la luz en el vacío no fuera constante a lo largo del tiempo, o ambas cosas (1 y 2), entonces la Teoría de la Relatividad tendría que ser formulada otra vez.

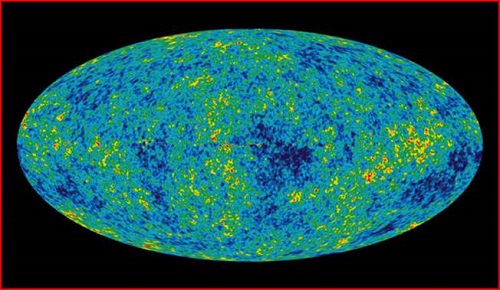

Tomemos primero la idea de un marco de referencia absoluto. En 1964, los científicos encontraron que la radiación de temperatura, representada en esta imagen, provenía de manera uniforme de todas partes del cielo. Se llama la radiación de fondo de microondas o radiación cósmica de microondas (en inglés, cosmic microwave background radiation, o CMBR). Esta es el "eco" del estado original súper caliente del universo, o la temperatura que quedó después de que el universo se expandiera y se enfriara. Esta temperatura de fondo es uniforme a 1 parte en 10,000. En este mapa de todo el cielo (en la imagen provista), las áreas rojas son ligeramente más cálidas que el promedio, y las áreas azules son ligeramente más frías que el promedio, en esta cantidad extremadamente pequeña: una décima parte de un grado. Ahora aquí está lo importante. Esta radiación cósmica de microondas (CMBR) proporciona un marco de referencia absoluto. La CMBR rodea todo el universo. Cuando algo, un planeta, nuestro sistema solar, nuestra galaxia, otra galaxia, cualquier cosa, se mueve, el movimiento tiene que ser hacia alguna sección del CMBR. Ese movimiento aparecerá como un cambio de temperatura tanto delante como detrás. Delante se mostrará como un poco más cálido y detrás como un poco más fresco. Para aquellos familiarizados con el término, este es un efecto Doppler. Los cambios de temperatura se pueden convertir matemáticamente en velocidad de movimiento. Hemos medido el movimiento de nuestro sol en nuestra galaxia, y el movimiento de nuestro Grupo Local de galaxias hacia otros grupos de galaxias en este contexto. Aquí se muestra el resultado final generalizado al sumar todas esas velocidades. La dirección y la velocidad del movimiento de cualquier objeto en el espacio pueden ser diferentes, pero esas velocidades pueden definirse individualmente por el CMBR. El astrofísico de la Universidad de Cornell, Martin Harwit, en su libro ‘Conceptos Astrofísicos,’ p. 178 (publicado por Springer-Verlag) comenta sobre este importante resultado de la CMBR: Pero luego trata de salvar lo que pueda de la teoría de la relatividad diciendo, "El establecimiento de un marco de referencia absoluto enfatizaría el hecho de que ... la relatividad en realidad solo tiene que ver con fenómenos a pequeña escala y que los fenómenos en escalas más grandes nos permiten determinar un marco de referencia preferido en el que los procesos cósmicos se ven isotrópicos." En otras palabras, el CMBR proporciona un marco de referencia absoluto para el movimiento en cualquier parte del universo. Entonces, la teoría de la relatividad de Einstein es incorrecta, excepto, posiblemente, para fenómenos a pequeña escala. Esto también significa que también es sospechoso el derivar cualquier resultado utilizando esos dos postulados (una velocidad constante de la luz y ningún marco de referencia absoluto). Uno de los partidarios que apoyaron más a Einstein fue el famoso físico y astrónomo británico, Sir Arthur Eddington. Él sugirió que había un mecanismo diferente disponible que producía los mismos resultados que la relatividad sin la necesidad de esos dos postulados restrictivos. Llegó a la siguiente conclusión y lo ilustró con un ejemplo:

La física ahora ya demuestra que la energía de punto cero hace precisamente eso. De hecho, todos los resultados principales de la relatividad ahora se pueden realizar simplemente usando la realidad de la Energía de Punto Cero y sus efectos. Esto se puede hacer de manera simple y sin la necesidad de matemáticas extrañas y complicadas, como lo han demostrado varios investigadores modernos en los últimos 20 años, quienes tienen sus escritos en revistas científicas, las cuales son revisadas por compañeros también científicos. Como puedes ver, lo que comenzó con mi curiosidad por las cambiantes medidas de la velocidad de la luz, fue el principio de un curso de investigación que ha tenido algunas consecuencias interesantes. Ha llevado a una comprensión de la realidad de la Energía de Punto Cero, que se ha ido acumulando con el tiempo. Esto parece responder a los problemas planteados por la velocidad de la luz y los datos atómicos, ya que nos ha llevado a la comprensión de que los procesos atómicos y la velocidad de la luz están relacionadas íntimamente con la EPC. La conclusión es que, en el universo primitivo, cuando la fuerza de la EPC era baja, la velocidad de la luz era más rápida y algunos procesos atómicos eran más rápidos. En nuestra próxima sesión, veremos cómo estos desarrollos, junto con la astronomía de plasma, abren una nueva ventana para comprender la cuestión del tiempo y algunos problemas astronómicos persistentes.

|